Die digitale Welt, in der wir heute leben, ist von Geschwindigkeit und Effizienz geprägt. Von unseren Smartphones bis hin zu den leistungsstärksten Servern – die zentrale Verarbeitungseinheit (CPU) ist das Herzstück jeder Rechenmaschine. Eine der faszinierendsten Entwicklungen in der Prozessorarchitektur der letzten Jahrzehnte ist die Fähigkeit eines einzelnen Kerns, mehrere Aufgaben scheinbar gleichzeitig zu bearbeiten. Dies ist vor allem durch die Einführung von Threads und Technologien wie dem Hyper-Threading von Intel möglich geworden. Doch warum können viele moderne Prozessorkerne zwei Threads effizient handhaben, aber nur selten vier oder mehr? Diese Frage führt uns tief in die Funktionsweise von CPUs und die Kompromisse, die bei deren Design eingegangen werden.

Um die Thematik zu verstehen, müssen wir zunächst klären, was ein Thread überhaupt ist. Im Wesentlichen ist ein Thread eine Abfolge von Befehlen, die von einem Programm ausgeführt werden soll. Ein Programm kann aus einem oder mehreren Threads bestehen. Traditionell konnte ein einzelner CPU-Kern nur einen Thread gleichzeitig bearbeiten. Hier kommt das Konzept des Simultaneous Multi-Threading (SMT) ins Spiel, das von Intel als Hyper-Threading bekannt gemacht wurde.

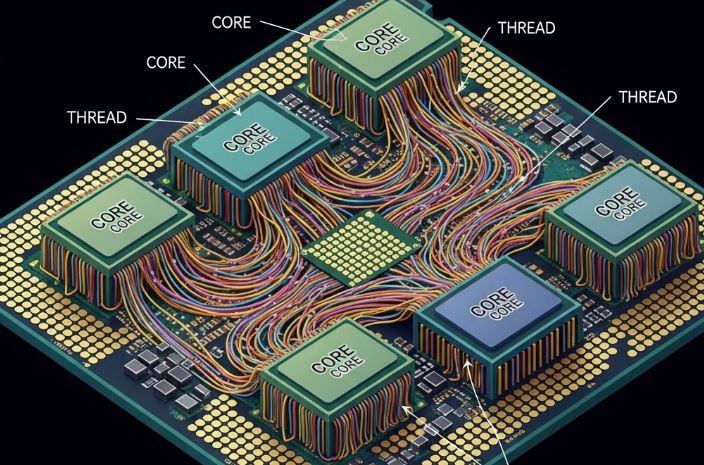

Hyper-Threading ermöglicht es einem einzelnen physischen CPU-Kern, sich dem Betriebssystem als zwei logische Kerne zu präsentieren. Dies bedeutet, dass der eine Kern zwei Threads parallel bearbeiten kann. Aber wie funktioniert das, und warum ist es auf zwei begrenzt? Der Trick liegt in der Ressourcennutzung. Moderne CPU-Kerne sind unglaublich komplex und verfügen über verschiedene Ausführungseinheiten: Arithmetisch-Logische Einheiten (ALUs), Gleitkommaeinheiten (FPUs), Lade-/Speichereinheiten und mehr. Oft werden nicht alle diese Einheiten gleichzeitig von einem einzigen Thread voll ausgelastet. Es gibt Leerlaufzeiten, in denen bestimmte Ressourcen nicht genutzt werden, während andere überlastet sind oder auf Daten warten.

Hier setzt Hyper-Threading an. Wenn ein Thread beispielsweise auf Daten aus dem Speicher wartet, kann der Kern in dieser Zeit die Ressourcen nutzen, die sonst ungenutzt blieben, um einen zweiten Thread zu verarbeiten. Es ist, als hätte man zwei Warteschlangen vor einem einzelnen Schalter, der in der Lage ist, zwei Anfragen gleichzeitig zu bearbeiten, solange sie unterschiedliche Fähigkeiten des Schalters benötigen. Die Effizienzsteigerung durch Hyper-Threading beruht darauf, dass die Lücken in der Ausführung eines Threads durch die Befehle eines anderen Threads gefüllt werden. Das Ergebnis ist eine bessere Auslastung der vorhandenen Hardware, was zu einer spürbaren Leistungssteigerung bei bestimmten Arten von Workloads führen kann, insbesondere bei solchen, die von hoher Parallelität profitieren.

Die Begrenzung auf zwei Threads pro Kern ist jedoch keine willkürliche Entscheidung, sondern das Ergebnis sorgfältiger Ingenieursarbeit und Design-Optimierung. Mit jedem zusätzlichen Thread, den ein Kern verwalten müsste, steigt die Komplexität der internen Steuerung massiv an. Die verschiedenen Threads würden zunehmend um dieselben begrenzten Ressourcen im Kern konkurrieren. Dies würde zu sogenannten Konflikten (Contentions) führen. Wenn mehrere Threads gleichzeitig versuchen, auf dieselbe Ausführungseinheit zuzugreifen, müssen sie sich abwechseln, was den potenziellen Leistungsgewinn schnell zunichte machen und im schlimmsten Fall sogar zu einer Verschlechterung der Leistung führen könnte.

Stellen Sie sich vor, Sie haben eine Küche mit einem Koch (dem Kern) und zwei Assistenten (den Threads). Wenn der erste Assistent Gemüse schneidet (nutzt die Schneideeinheit), kann der zweite Assistent gleichzeitig Fleisch braten (nutzt die Brateinheit). Beide nutzen unterschiedliche Ressourcen und arbeiten effizient zusammen. Würden Sie aber einen dritten oder vierten Assistenten hinzufügen, würden sie sich schnell gegenseitig im Weg stehen, um den Herd oder das Schneidebrett streiten und die Arbeitsabläufe würden sich verlangsamen, anstatt sich zu beschleunigen.

Ein weiterer entscheidender Faktor ist der Cache-Speicher. Jeder Kern verfügt über mehrere Ebenen von Cache-Speicher (L1, L2, L3), die dazu dienen, häufig benötigte Daten schnell zugänglich zu machen. Wenn zwei Threads dieselben Cache-Zeilen nutzen können, kann dies die Effizienz steigern. Wenn jedoch zu viele Threads um den begrenzten Cache-Platz konkurrieren, führt dies zu häufigeren Cache-Fehlern (Cache Misses), was bedeutet, dass der Kern öfter auf den langsameren Hauptspeicher zugreifen muss. Dies würde den Vorteil der Parallelisierung zunichtemachen.

Die Ingenieure von Intel und anderen Prozessorherstellern haben festgestellt, dass der Zugewinn an Effizienz und Leistung durch die Implementierung von zwei Threads pro Kern den zusätzlichen Aufwand in Bezug auf Komplexität und Energieverbrauch rechtfertigt. Ein dritter oder vierter Thread pro Kern würde jedoch eine exponentiell höhere Komplexität der Scheduling-Algorithmen und der Hardware-Ressourcenverwaltung erfordern, ohne einen proportionalen Leistungszuwachs zu bieten. Der Punkt, an dem der Nutzen die Kosten übersteigt, ist in der Regel bei zwei Threads erreicht.

Es ist auch wichtig zu beachten, dass die Prozessorarchitektur ständig weiterentwickelt wird. Anstatt die Anzahl der Threads pro Kern über zwei hinaus zu erhöhen, konzentrieren sich die Hersteller darauf, die Anzahl der physischen Kerne auf einem einzigen Chip zu erhöhen. Dies ist der Grund, warum wir heute CPUs mit 8, 16, 32 oder sogar mehr physischen Kernen sehen, wobei jeder dieser Kerne oft zwei Threads unterstützt. Diese Multi-Core-Architektur bietet einen skalierbareren und effizienteren Weg zur Erhöhung der Gesamtleistung eines Systems. Jeder physische Kern hat seine eigenen dedizierten Ressourcen und einen eigenen Cache, was die Konflikte minimiert und die Leistung linearer skaliert.

Zusammenfassend lässt sich sagen, dass die Begrenzung auf zwei Threads pro Kern eine wohlüberlegte Designentscheidung ist, die auf einem tiefen Verständnis der Prozessorarchitektur, der Hardware-Ressourcenverwaltung und der Leistungscharakteristika von Anwendungen basiert. Während die Technologie weiterhin Fortschritte macht, bleibt das Prinzip der optimalen Auslastung der vorhandenen Ressourcen das oberste Gebot bei der Entwicklung der nächsten Generation von CPUs. Es ist ein faszinierendes Beispiel dafür, wie komplexe technische Herausforderungen durch kluge Ingenieurkunst gelöst werden, um die Grenzen der Rechenleistung immer weiter zu verschieben.